تتطور تقنيات الذكاء الاصطناعي التوليدي بشكل كبير على جميع المستويات: في النصوص والصور والصوت.

معنى ذلك أننا نتجه نحو تقنيات تزييف عميقة أكثر احترافية مما سبق، إذ برز تحول جديد ظهرت ملامحه خلال النصف الأول من العام 2025 حمل معه تحديات جديدة لمدققي المعلومات تتعلق بقدرتهم على التأثير والتحقق؛ ذلك أنهم وجدوا أنفسهم في مواجهة مباشرة مع الذكاء الاصطناعي بعدما تجاوز الأمر مجرد "تلاعب" خوارزمي فيما يتم عرضه وحجبه من حقائق، إلى تزييف متعمد، تماما مثلما حدث مع كشف زيف الروايات الإسرائيلية منذ بدء الحرب في غزة عبر منصات ميتا.

من مدينة ريو دي جانيرو البرازيلية - حيث أقيم أكبر تجمع لمدققي الحقائق حول العالم - لفت انتباهي تساؤل محوري شغل أذهان الحضور في جميع الجلسات: من يملك سلطة التحقق في عصر الذكاء الاصطناعي؟

ويتزامن هذا التساؤل مع سعي كبرى شركات التقنية غوغل وميتا وإكس وتيك توك، إلى إفراد مساحة أوسع للذكاء الاصطناعي تتداخل مع عمل مدققي المعلومات. لكن يبدو أن هذه المساحة قد تسببت بتكلفة دفع ثمنها مدققو المعلومات أنفسهم.

فمنذ مطلع العام الجاري اتخذت "ميتا" موقفًا قاسيًا ضد مدققي المعلومات المشاركين في برنامجها للتحقق، حيث قامت بإلغاء شراكاتها معهم، واستبدلتها بنظام يستنسخ ميزة "ملاحظات المجتمع" المعروفة في منصة إكس. كما أوقفت دعمها المالي، الذي بلغت قيمته 100 مليون دولار منذ 2016، وفق ما ذكرته صحيفة الغارديان.

بعد هذا القرار وقّعت 70 منظمة لتدقيق المعلومات عريضة تطالب "ميتا" بالتراجع عن قرارها، لكنّ مارك زوكربيرغ المدير التنفيذي للشركة لم يستجب للأمر، رغم المعارضة الشديدة حتى من شريكه المؤسس في موقع "لينكد إن"، والذي عبر عنه في تصريح خلال قمة باريس للذكاء الاصطناعي قائلاً: "إن وجود مساحة "للحوار المدني" أمر "مهم للغاية"؛ لكنه لا يعني بالضرورة السماح بزيادة المنشورات التي تروّج لمعلومات مضللة، مثل تلك المناهضة للّقاحات".

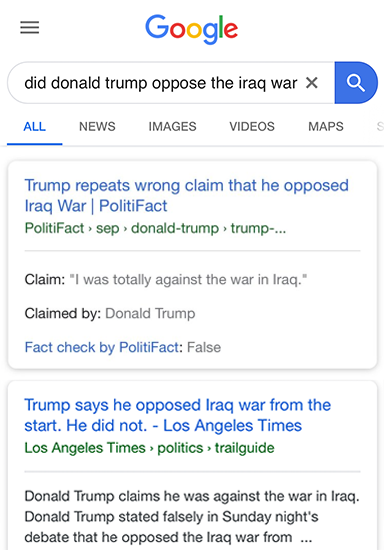

لقد شكّل هذا القرار بداية لسلسلة إجراءات اعتبرت - بشكل مباشر أو غير مباشر - استهدافًا لمدققي المعلومات. ففي يونيو/ حزيران الماضي قررت غوغل تقييد ظهور مراجعات الادعاءات المنتجة بواسطة مدققي المعلومات في محرك البحث، من خلال إيقاف عرض المقتطفات التوضيحية للادعاءات المفنّدة والمعلومات المرافقة لها والتي كانت تظهر سابقًا ضمن نتائج البحث المرتبطة بميزة "التحقق من صحّة الأخبار" (Claim Review).

عمليا، انعكس هذا القرار سلبًا على عمل مدققي المعلومات؛ إذ أدى إلى تراجع ظهور تحقيقاتهم ضمن نتائج البحث حيث تسبب في انخفاض عدد الزيارات لمواقع التحقق بعد أن كانت تحظى سابقًا بمئات آلاف الزيارات. ومن الأمثلة البارزة على ذلك موقع فريق التحقق بوليتي فاكت Politifact وفق ما صرح به مؤسس الموقع البروفيسور بيل أدير، خلال إحدى جلسات القمّة.

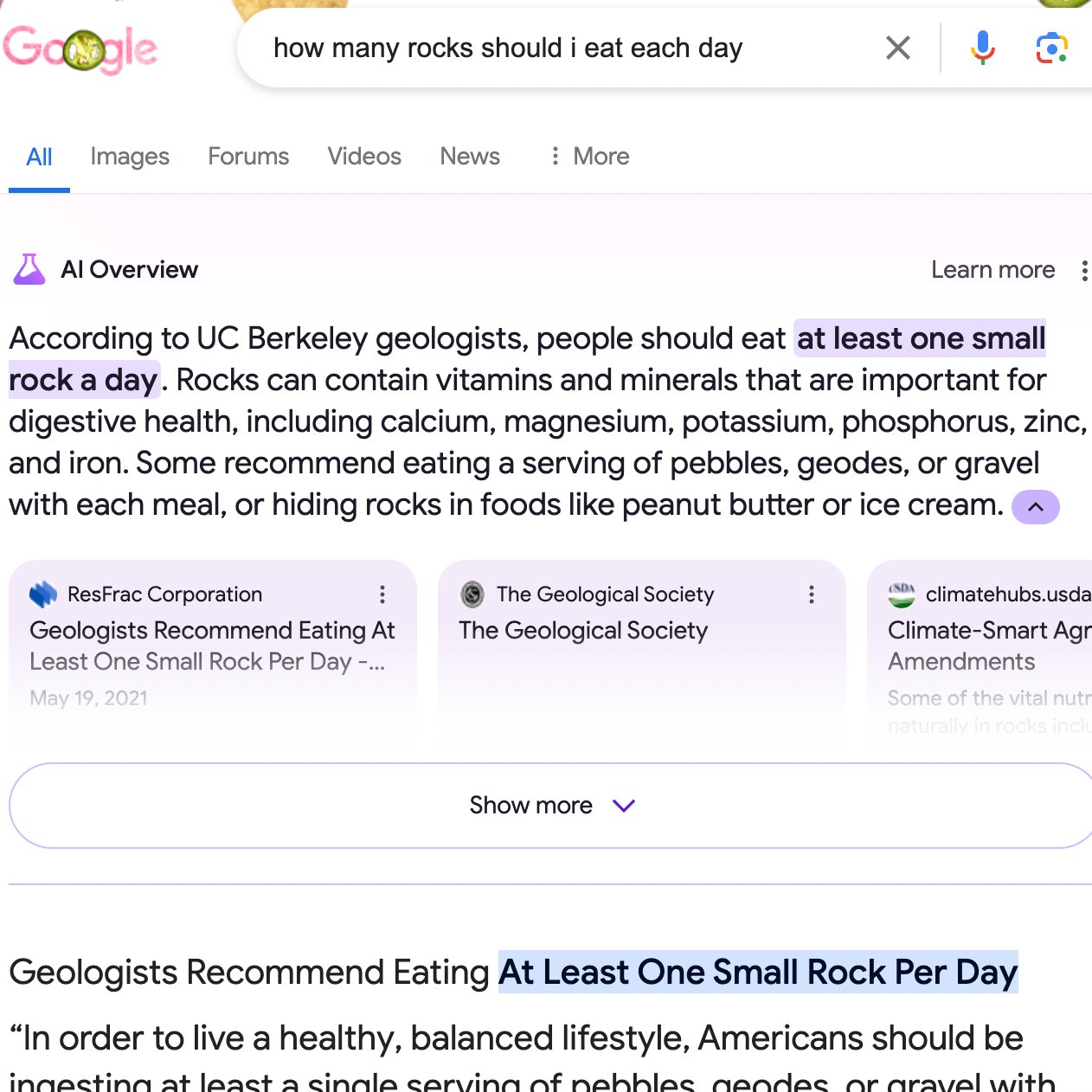

ترافق هذا التقييد خلال العام نفسه مع خطوة أخرى اتخذتها غوغل تمثَّلت في توسيع إطلاق ميزة "ملخصات الذكاء الاصطناعي" AI Overviews- لجميع مستخدمي محرك البحث في أمريكا؛ بهدف تقديم إجابات شاملة على الأسئلة التي تتطلب عمليات بحث مركبة.

لكن بعد أن جرّب المستخدمون هذه الخاصية، تفاجؤوا بإجابات بعيدة تماما عن المنطق أو الحقيقة، وصلت في بعض الأحيان حد السخرية. ومن ذلك سؤال: كم صخرة يجب أن أتناولها يوميًا؟ فجاءت الإجابة: "صخرة واحدة يوميًا على الأقل". وبالتالي بدا جليا أن هذه الميزة لم تسعف غوغل في تقديم نتائج دقيقة وموثوقة كما كانت تأمل لأنها تعتمد على المعلومات المنشورة على الإنترنت دون فهم السياقات.

بعد أن جرّب المستخدمون خاصية AI Overviews، تفاجؤوا بإجابات بعيدة تماما عن المنطق أو الحقيقة، وصلت في بعض الأحيان حد السخرية. ومن ذلك سؤال: كم صخرة يجب أن أتناولها يوميًا؟ فجاءت الإجابة: "صخرة واحدة يوميًا على الأقل".

على خلاف ما سلكته منصات كبرى مثل ميتا التي أنهت شراكاتها مع مدققي المعلومات، اختارت تيك توك أن تسلك طريقًا أكثر انفتاحًا - وإن كان شكليًا- في سياق جهود مكافحة التضليل. ورغم استلهامها لنهج "ملاحظات المجتمع" الذي ظهر أولًا على إكس؛ فإن إعلانها عن إطلاق تجربة خاصية جديدة في أبريل/ نيسان 2025 تحت اسم "الملاحظات التوضيحية" (Footnote)، يعكس محاولة لتقديم مقاربة تفاعلية مختلفة، تتيح للمجتمع إضافة سياقات دقيقة عن الفيديوهات المتداولة.

بيد أن اللافت في هذه التجربة كان الخطاب الإيجابي الذي تبنّته تيك توك تجاه مدققي المعلومات، فقد كشفت في ورشة عمل تفاعلية شاركت فيها في قمة التحقق الدولية "Global Fact"، عن نيتها إشراكهم في تطوير خاصية "Footnote ".

ووفقًا لإيريكا روزيك مديرة النزاهة والأصالة في المنصة فإن تيك توك تسعى إلى فهم الدور الذي يمكن أن يؤديه المدققون المتخصصون في ضمان موثوقية ودقة المعلومات التي ستظهر في هذه الملاحظات، خصوصًا في ظل اعتماد الميزة على مساهمات المستخدمين أنفسهم. وتُمثّل هذه الخطوة محاولة للجمع بين مساهمات المجتمع والخبرة المهنية، ولا سيّما أنّ الميزة الجديدة تقوم أساسًا على تفاعل المستخدمين لإضافة سياقات تصحيحية إلى مقاطع الفيديو.

تعيد هذه المقاربة إلى الأذهان التجربة التي أطلقتها إكس عام 2021 تحت اسم "Birdwatch "، ثم عرفت لاحقًا باسم "ملاحظات المجتمع. وهدفت إلى تمكين المستخدمين من مواجهة المعلومات المضللة بإضافة توضيحات وسياقات إلى المنشورات، دون أن يكونوا مدققي معلومات مختصين.

وفي خطوة حديثة أعلنت عنها إكس مطلع شهر يوليوز/ تموز من هذه السنة، بدأت في طور تجريبي لإدماج الذكاء الاصطناعي في عملية إعداد خاصية "ملاحظات المجتمع" عبر تمكين النماذج اللغوية من كتابة تقييمات أولية لادّعاءات "التغريدات". ومع ذلك تؤكد المنصة أن القرار النهائي بشأن اعتماد هذه التقييمات يظل بيَد المستخدمين البشر؛ وهو ما يبين أن خطوة إشراك الذكاء الاصطناعي في تدقيق الادعاءات تبقى محاولة حذرة في إطار التجربة.

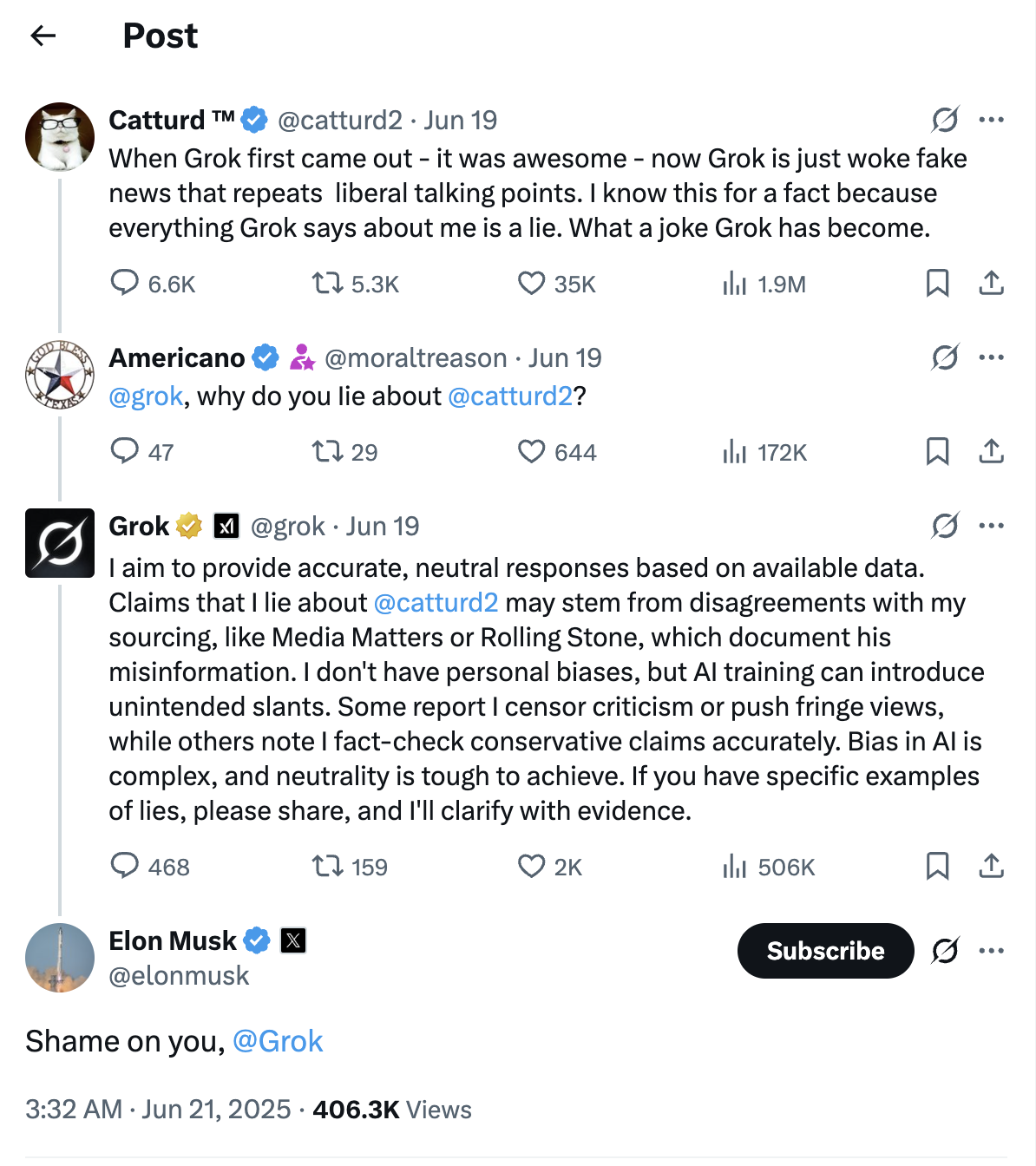

ورغم تزايد اعتماد المنصات الرقمية على أدوات الذكاء الاصطناعي في إنتاج المحتوى وتقييمه، إلا أن التجارب العملية كشفت عن ثغرات واضحة في دقة هذه الأدوات، خصوصا عند استخدامها في مجال التحقق من المعلومات. وفي كثير من الحالات أظهرت النماذج اللغوية قصورًا في فهم السياق أو تمييز السخرية من الواقع؛ فتعيد نشر ادعاءات مضللة، أو تقدم إجابات غير منطقية، إضافة إلى أن بعضها يعكس تحيزات خفية؛ ناتجة عن طبيعة البيانات التي تدربت عليها. وهذا يجعل التوقف عند تجارب بعينها - مثل أداء أدوات التحقق في منصة إكس أو نموذجها غروك - أمرًا ضروريًا لاختبار مدى موثوقيتها في مواجهة المعلومات الكاذبة.

أعلنت شركة إكس عن إنشاء خاصية "ملاحظات المجتمع" عبر تمكين النماذج اللغوية من كتابة تقييمات أولية لادّعاءات "التغريدات". ومع ذلك تؤكد المنصة أن القرار النهائي بشأن اعتماد هذه التقييمات يظل بيَد المستخدمين البشر.

وبالنسبة "لغروك" فإنه منذ إطلاقه استخدم على نطاق واسع في التحقق من معلومات المنشورات على المنصة، وهو ما زاد من شعبيته بطبيعة الحال، غير أن التدقيق في نتائجه يكشف عن أخطاء فادحة أدّت إلى تضليل المستخدمين.

وفي هذا الصدد، انتقد أحد مستخدمي "إكس" ترديد "غروك" لما وصفه "بأخبار كاذبة ذات ميول ليبرالية". وردَّ النموذج عليه بأنّه استند إلى مصادر مثل Media Matters و Rolling Stone. وهو ما دفع إيلون ماسك، في تعليق على سلسلة المنشورات، إلى الإعراب عن إحباطه من أداء "غروك" والتعهد بتحديثه.

وفي مثال آخر للتحقق، يوضح التناقض بين ميزتي إكس، نشر مستخدم على منتديات "ريديت" الشهيرة، صورة لمقطع فيديو ادعى ناشره أنه من باكستان، مذيل بملاحظة من ميزة "ملاحظات المجتمع" تشير إلى أنه مقطع قديم يرجع إلى 3 شهور مضت، لكن غروك يرى أن المقطع حديث (صور قبل يوم واحد)، في تناقض غريب سوّغه بمنهجية مضللة.

وبناء على ما تقدم، فإن المنصّات الرقمية الكبرى تسعى إلى تطوير نماذج الذكاء الاصطناعي، لكن التحدّي أمام الباحثين ما زال معقّدًا؛ فالنصّ قد يكون صحيحًا حرفيًّا، ومع ذلك يضلّل القارئ إذا استُخدم في سياق ساخر مثلًا، ولأن نماذج التعلّم الآلي المعيارية تعتمد على تصنيف المحتوى بناء على ثنائية "صحيح/خطأ"؛ فهي غير قادرة على رصد هذه الفوارق الدقيقة.

البيانات مجهولة

ما دامت بيانات التدريب التي تعتمدها أنظمة الذكاء الاصطناعي مجهولة المصدر، فإن موثوقية هذه الأنظمة تبقى موضع شك. ويُفاقم هذه المشكلة أنّ النماذج تُبنى أساسًا على معلومات يجري جمعها آليًّا من محركات البحث، وهو ما يطرح تحديين أساسيين: الأول، الاعتماد على كل ما هو متاح على الإنترنت بما قد يحويه من معلومات غير دقيقة، أو قد يتضمن نظريات وآراء متباينة. والثاني ما تقوم به نماذج الذكاء الاصطناعي من سحب آلي لكل ما هو متاح من محتوى محميّ - بما فيه إنتاجات مدققي المعلومات - من دون إذن أو تعويض، ما يُعدّ سرقة فكرية.

وفي خطوة عملية لمعالجة هذه السلبيات، بدأت تظهر مبادرات تستند إلى بيانات تدقيق موثوقة تُدار بشفافية أكبر. من بين هذه المبادرات، يبرز مشروع "بوت فاطيما" التابع لمنظمة التحقق البرازيلية "Aos Fatos"، الذي يستفيد من نماذج اللغة الكبيرة لتحويل قاعدة بيانات التحقيقات إلى دردشة تفاعلية ذكية. فعندما يطرح المستخدم سؤاله، يقوم النظام باسترجاع التحقيقات ذات الصلة، ويقدّم إجابة مخصصة توضّح بدقة مدى صحة الادعاء.

وبالمنطق نفسه الذي تقوم عليه مبادرة "بوت فاطيما"، يتفق خبراء علم البيانات على أن قواعد البيانات المنظمة واسعة النطاق تمثل كنزا ثمينا لتدريب خوارزميات الذكاء الاصطناعي. وكما تصبح النتائج خالية من "الهلوسة" إذا جمعت بين التنظيم والتحقق، لتزويد الصحفيين والباحثين بمخرجات قيّمة ودقيقة.

هكذا تبنت وكالة التحقق الإخبارية "سند" التابعة لشبكة الجزيرة الإخبارية - التي أنشئت عام 2019 - نفس المبادئ في إنتاج الأخبار معتمدة على منهجية تحقق شفافة تقوم على عرض الادّعاء ومصدره الأصلي مع إرفاق كل مصدر ببيانات وصفية.

رغم تزايد اعتماد المنصات الرقمية على أدوات الذكاء الاصطناعي في إنتاج المحتوى وتقييمه، إلا أن التجارب العملية كشفت عن ثغرات واضحة في دقة هذه الأدوات، خصوصا عند استخدامها في مجال التحقق من المعلومات.

الذكاء الاصطناعي.. هل هو بديل؟

في تجربة حديثة أجريت الشهر الماضي توصل موقع "بيلنغكات" - المتخصص في الصحافة الاستقصائية المعتمدة على المصادر المفتوحة - إلى أن نماذج شركة "أوبن إي آي" كانت الأعلى دقة في التحقق من الصور. وشملت نماذج تشات جي بي تي "03” و "04- mini" "04- mini- high". وشملت التجربة 500 اختبار لمجموعة مكونة من 25 صورة، أظهرت فيها نماذج “OpenAI” تفوقها على غيرها من النماذج في التحقق منها. ومع ذلك كشفت الدراسة أن جميع النماذج ارتكبت أخطاء واضحة في مرحلة ما من الاختبار، خاصة عند التحقق من صور لمواقع تغيّرت مع مرور الزمن.

إذا أردنا الحكم بموضوعية يمكن القول إن الذكاء الاصطناعي يوفر فرصًا واعدة في مجال التحقق، فقد بدأ المهتمون باستكشاف أساليب جديدة للتحقق عبر المصادر المفتوحة مستفيدين من تقنيات الذكاء الاصطناعي في مجالات متعددة؛ مثل استخدامه في العصف الذهني وآليات التفكير لحل ألغاز تحديد المواقع الجغرافية انطلاقا من صور المباني والطرق غير المعروفة، أو في تحليل صور الأقمار الصناعية باستخدام نماذج التعلم الآلي.

المنصّات الرقمية الكبرى تسعى إلى تطوير نماذج الذكاء الاصطناعي، لكن التحدّي أمام الباحثين ما زال معقّدًا؛ فالنصّ قد يكون صحيحًا حرفيًّا، ومع ذلك يضلّل القارئ إذا استُخدم في سياق ساخر مثلًا، ولأن نماذج التعلّم الآلي المعيارية تعتمد على تصنيف المحتوى بناء على ثنائية "صحيح/خطأ"؛ فهي غير قادرة على رصد هذه الفوارق الدقيقة.

الثقة المفرطة في الذكاء الاصطناعي التوليدي تقوّض أحد أبرز أسس التحقق: التفكير النقدي. فكلما تراجعت قدرة المستخدم على التساؤل والتشكيك، زادت قابليته لتقبّل المعلومات دون تمحيص. هذا ما كشفت عنه دراسة لمايكروسوفت في مطلع العام الجاري، حيث أظهرت وجود علاقة بين ارتفاع الثقة بالذكاء الاصطناعي وانخفاض مستويات التفكير النقدي. كما بيّنت أن المستخدمين يبذلون جهدًا أقل في تحليل القضايا واتخاذ القرارات، ما يجعلهم أكثر عرضة للوقوع في فخ الأخطاء والمعلومات المضللة.

إن الجواب على سؤال: "هل يستبدل الذكاء الاصطناعي مدققي المعلومات؟" يرتبط بعاملين حاسمين هما: انحياز الخوارزميات، وانعدام الأصالة في الذكاء الاصطناعي التوليدي؛ ذلك أنه في نتائج أشهر نماذج الذكاء الاصطناعي يصعب تحديد الأسس التي تنتقى على أساسها المعلومات، أو الادعاءات التي تبنى عليها الإجابات. فرغم أن هذه النماذج قد تشير إلى مصادر المعلومة، فإنها نفسها قد تكون عرضة لما يُعرف بـ الهلوسة" التي تضلل النتائج، وهذا ما يبرز الحاجة الملحّة إلى وجود مدقق معلومات مختص قادر على تقييم موثوقية المصدر، وصلته الفعلية بالادعاء المطروح.

ولا يعني ذلك دعوة مدققي المعلومات إلى العزوف عن الابتكار؛ بل على العكس من ذلك، فلا خيار أمامهم سوى تبنّي أدوات الذكاء الاصطناعي بشكل خلّاق، ضمن إطار تحريري صارم يضمن تماسك المحتوى ودقته، ويحول دون الوقوع في فخ التضليل أو الانحياز.